GPUサーバーとは

GPUを搭載したAI用途のサーバーは、

機械学習のトレーニングから推論まで幅広い用途に利用され、

あらゆる業界のビジネスのスピードと効率性を大きく向上させます。

GPUサーバーと

一般的なサーバーの違い

GPUサーバー

GPUサーバーは、グラフィックス処理ユニット(GPU)の搭載・利用を念頭に設計されています。GPUサーバーは、高度なグラフィックス処理、ディープラーニング、機械学習、生成AI、LLM(大規模言語モデル)、科学技術計算など、大量のデータを並列に処理する用途に特化しています。

GPUは、多数のコアを持ち、並列処理能力が高いため、特定のタスクにおいてCPUよりも遥かに高速な計算が可能です。特にディープラーニングなどの機械学習タスクでは、GPUの利用が一般的で、トレーニングと推論の処理を効率的に行うことができます。

一般的なサーバー

一般的なサーバーは、CPUを中心に設計されており、主に一般的なコンピュータータスクを実行することに特化しています。ファイルの保存と共有、データベースの管理、Webサイトのホスティング、電子メールの配信など、広範な一般的なタスクを実行します。

一般的なサーバーは、CPUのコア数やクロックスピードを重視することが多いため、一つのタスクを逐次的に処理するのが得意です。しかし、大規模な並列処理や高度なグラフィックス処理には向いていません。

一方でGPUは発熱が大きく大電力が必要となるため、専用の冷却機構と大容量の電源ユニットが必要になります。

GPUの冷却方式

パッシブクーリングタイプ

主にエンタープライズ用途の高性能GPUに採用される冷却方式で、1台のサーバーに複数枚のGPUを搭載しても吸気の問題が発生しないようにGPU自体にはFANがなく、ヒートシンクだけが搭載されています。

高性能GPUは発熱量が大きく、冷却するためにはGPUヒートシンク内に大量の風を送り込む必要があり、専用の筐体エアフロ―設計および強力なFANを多数内蔵したGPUサーバに搭載する必要があります。

パッシブクーリングに対応したGPUサーバーは騒音・消費電力共に大きいためデータセンター等のAC200V電源を備えたサーバールームに設置する必要があります。

アクティブクーリングタイプ

オープンエアータイプ

オープンエアータイプは、主にゲーミング用途などのコンシューマGPUで採用される冷却方式です。

大口径のFANを複数搭載することで低い回転数で冷却できるため静音化しやすい一方、ヒートシンクが巨大でラックマウントサーバには搭載できず、タワーケースに搭載します。

GPUメーカーによってサイズ・形状・占有スロット数が異なるため1台のPCに複数枚搭載する場合に物理的に干渉する場合があります。

またヒートシンクからの排熱はGPUの周囲に放出されるため、PCケース内から外部へ排気するためのFANが別途必要になります。

ブロワータイプ

ブロワータイプは、側面にあるFANから空気を取り込んでヒートシンクに送り、ブラケットの開口部からケース外に排熱する方式です。

主にプロフェッショナル用途のGPUで採用される冷却方式で、形状が一定であるため隣り合ったPCIeスロットに複数枚搭載することができ、ラックマウントサーバ/タワーケースどちらにも搭載することができます。

但しヒートシンクおよびFANサイズに制限があるため高い回転数が必要で、オープンエアタイプに比べて動作音が大きくなり、冷却可能なTDPにも上限があります。

GPUの種類と用途

コンシューマー向けGPU

デスクトップPCやゲーミングPCなどに搭載されるGPUです。

NVIDIA GeForce、AMD Radeonなどが代表的なブランドです。これらのGPUはグラフィックス処理やゲームの実行に優れています。

冷却方式は基本的にオープンエアタイプとなり、カード形状はPCIeスロットに取り付ける方式で、

TDPに応じてヒートシンクが巨大になるため占有スロットは1~4まで様々です。

NVIDIA

Geforce RTXシリーズ

AMD

Radeon RXシリーズ

プロフェッショナル向けGPU

ワークステーションやサーバに搭載されるGPUです。

NVIDIA RTXシリーズ(旧Quadro系)、AMD Radeon PROシリーズが代表的なブランドです。

CGデザインやCAD、デジタルコンテンツ制作などのプロフェッショナル用途およびAI・ディープラーニングの学習・推論用途に適しています。

冷却方式は基本的にブロワータイプとなり、カード形状はPCIeスロットに取り付ける方式で、占有スロットは1または2スロットです。

NVIDIA

RTXシリーズ

NVIDIA

Tシリーズ

AMD

Radeon PROシリーズ

データセンター向けGPU

データセンター向けのGPUは、高度な計算タスクやデータ処理を行うために最適化されています。

これらのGPUは、科学技術計算、機械学習、生成AIなどの分野で広く使用されます。

NVIDIA Data Center / TeslaシリーズやAMD Instinct MI シリーズ・アクセラレーターなどが

データセンター向けの代表的な製品となります。

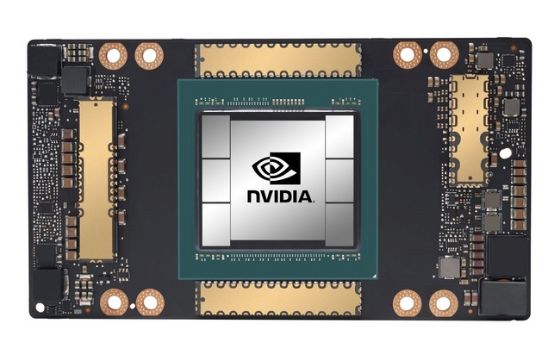

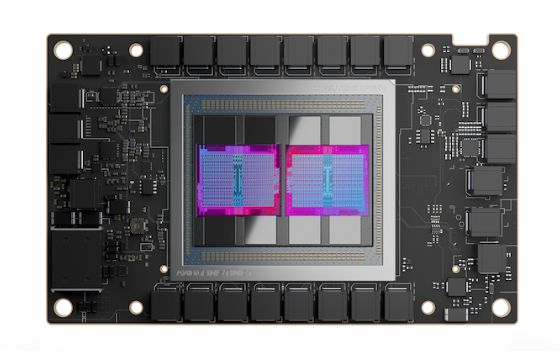

冷却方式は基本的にパッシブクーリングとなり、形状はPCIeスロットに取り付けるカード方式のモデルと、

ベースボードに直接取り付ける方式(SXM,OAM)のモデルがあります。カードの場合の占有スロットは1または2スロットです。

性能をスケールアップするために複数のGPUをサーバに搭載することができ、

GPU間で直接データをやり取りするための仕組みを備えています。

NVIDIA

HPC向け (PCIe)

NVIDIA

エッジ向け (PCIe)

NVIDIA

vGPU向け (PCIe)

NVIDIA

HPC向け (SXM基板)

AMD

Instinct MI (PCIe)

AMD

Instinct MI (OAM基板)

GPU別に見る最適な用途

| Solution Gategory |

GPU |

Deep Learning Training and Data Analytics |

Deep Learning Inference |

HPC / AI |

NVIDIA Omniverse™ / Render Farms |

Virtual Workstation |

Virtual Desktop (VDI) |

Mainstream Acceleration |

Far-Edge Acceleration |

||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| type | PCIe | SXM | PCIe | SXM | PCIe | SXM | PCIe | SXM | PCIe | SXM | PCIe | SXM | PCIe | SXM | PCIe | SXM | |

| Compute | H100 | ★★★ | ★★★ | ★★★ | ★★★ | ★★★ | ★★★ | ★★★ | |||||||||

| A100 | ★★ | ★★ | ★★ | ★★ | ★★ | ★★ | ★★ | ||||||||||

| A30 | ★ | ★ | ★ | ||||||||||||||

| Graphics and Compute |

L40 | ★★★ | ★★★ | ★★★ | ★★★ | ||||||||||||

| A40 | ★★ | ★★ | ★★ | ||||||||||||||

| A10 | ★ | ★ | ★★★ | ★★ | ★ | ★★ | |||||||||||

| A16 | ★ | ★★★ | |||||||||||||||

| Small Form Factor (SFF) Compute and Graphics |

L4 | ★★★ | ★ | ★★★ | ★★★ | ★★★ | ★★★ | ||||||||||

| A2 | ★★ | ★★ | ★★ | ★★ | ★★ | ||||||||||||

| T4 | ★ | ★ | ★ | ★ | ★ | ||||||||||||

GOOD ★ BETTER ★★ BEST ★★★

用途や予算に応じた構成例

エントリーモデル

| 費用感 | 30万円~100万円 (参考価格) |

|---|---|

| 想定ユーザー | CAD・AI開発初級者 |

| 筐体 | ミドルタワー |

| 搭載可能GPU | Geforce RTX4070 /RTX4080 / RTX4090 NVIDIA RTX A2000 / A4000 / A4500 / A5000 / A5500 /A6000 等 |

| GPU数 | 最大1基 |

| 構成例 | Core i7-13700 8コア 2.1GHz x1基 DDR5-4400 16GB 960GB M.2 NVMe SSD NVIDIA RTX A2000 x1 |

| 最大消費電力 | 約500W~1000W (AC100V) |

| 設置場所 | デスクサイド |

スタンダードモデル

| 費用感 | 80万円~300万円 (参考価格) |

|---|---|

| 想定ユーザー | CAD・VR・AI開発・大学研究室など |

| 筐体 | ミドルタワー |

| 搭載可能GPU |

Geforcr RTX4070 /RTX4080 / RTX4090 NVIDIA RTX A2000 / A4000 / A4500 / A5000 / A5500 /A6000 / 6000Ada 等 |

| GPU数 | 最大2基 |

| 構成例 |

Xeon W-2435 8コア 3.1GHz x1基 DDR5-4800 ECC-RDIMM 32GB 960GB M.2 NVMe SSD NVIDIA RTX A5000 x2 |

| 最大消費電力 | 1000W (AC100V) / 1200W (AC200V) |

| 設置場所 | デスクサイド |

ハイエンドモデル

| 費用感 | 150万円~800万円 (参考価格) |

|---|---|

| 想定ユーザー | VDI・3Dレンダリング・AI学習用途・HPC 大学・研究機関・ビジネス用途 |

| 筐体 | フルタワー/4U |

| 搭載可能GPU |

Geforce RTX4070 /RTX4080 / RTX4090 NVIDIA RTX A4000 / A5000 / A5500 /A6000 / 6000Ada / A30 / A100 / L4 / L40 / L40S / H100 AMD Instinct MI210 |

| GPU数 | 最大4基 |

| 構成例 |

Intel Xeon スケーラブル 第4世代 x2基 DDR5-4800 ECC-RDIMM 256GB 960GB U.2 NVMe SSD NVIDIA RTX 6000Ada x4 |

| 最大消費電力 | 1000W (AC100V) / 1800W (AC200V) |

| 設置場所 | デスクサイド / サーバールーム |

アドバンストモデル

| 費用感 | 500万円~4000万円 (参考価格) |

|---|---|

| 想定ユーザー |

VDI・3Dレンダリング・AI学習用途・HPC・クラウドサービス 大学・研究機関・ビジネス用途 |

| 筐体 | 4U |

| 搭載可能GPU |

NVIDIA RTX A4000 / A5000 / A5500 /A6000 / 6000Ada / A10 / A30 / A40 / A100 / L40 / L40S / H100 AMD Instinct MI210 Intel Data Center GPU Max 1100 |

| GPU数 | 最大8基 |

| 構成例 |

Intel Xeon スケーラブル 第4世代 or AMD EPYC 9004 x2基 DDR5-4800 ECC-RDIMM 512GB 960GB U.2 NVMe SSD NVIDIA RTX 6000Ada x8 |

| 最大消費電力 | 1000W (AC100V) / 2700W (AC200V) |

| 設置場所 | サーバールーム |

エンタープライズモデル

| 費用感 | 5000万円~ (参考価格) |

|---|---|

| 想定ユーザー | 生成AI・大規模言語処理(LLM)・創薬・気象モデリング等 |

| 筐体 | 8U |

| 搭載可能GPU | NVIDIA SXM HGX H100 (80GB) |

| GPU数 | 8基 |

| 構成例 |

Intel Xeon Platinum 8480+ (56コア) x2基 DDR5-4800 ECC-RDIMM 2TB 3.84TB U.2 NVMe SSD x8 NVIDIA SXM HGX H100 (80GB) x8 |

| 最大消費電力 | 約10000W (AC200V) |

| 設置場所 | サーバールーム |

自社製カスタマイズモデル(一例)

| 費用感 | 200万円 (参考価格) |

|---|---|

| 想定ユーザー | CAD・VR・AI開発・大学研究室など(100V環境でもOK) |

| 筐体 | タワー |

| 搭載可能GPU |

Geforce RTX4080 / RTX4090 NVIDIA A6000 / 6000Ada 等 |

| GPU数 | 最大4基 |

| 構成例 |

Xeon W-3435X 16コア 3.1GHz x1基 DDR5-4800 ECC-RDIMM 256GB 960GB M.2 NVMe SSD Geforce RTX4090 x4 |

| 最大消費電力 | 約2000W (AC100V) |

| 設置場所 | デスクサイド |

「GPUサーバーその他の製品」についてはこちらから

さまざまな業界・用途で活用される

GPUサーバー

GPUを搭載したAI用途のサーバーは、

機械学習のトレーニングから

推論まで幅広い用途に利用されています。

製 造

製造プロセスの最適化や品質管理、

自動運転車のデータから、安全性や

運転の最適化。

医 療

患者のデータを学習し、

病気の早期発見や治療の

最適化。

金 融

予測モデルを株価の動向や信用リスクの評価等の意思決定に活用。

小 売

顧客の嗜好を予測し、個別に適した

商品を提案するなどの販売戦略の

最適化。

お客様の利用目的に応じて最適な製品をご提案させていただきます。

ご購入後の製品についてのサポートも行っております。

サンウェイテクノロジーでは、ご購入後の製品を安心してご利用いただけますよう、会員登録をお願いしております。

会員登録をしていただくことで、ご登録情報をもとに専用のサポート窓口や、修理・メンテナンスのご依頼、会員様向けQ&Aなどを便利にご利用いただけます。

新規会員登録はこちら

新規会員登録はこちら すでに登録済みの方はこちら

すでに登録済みの方はこちら